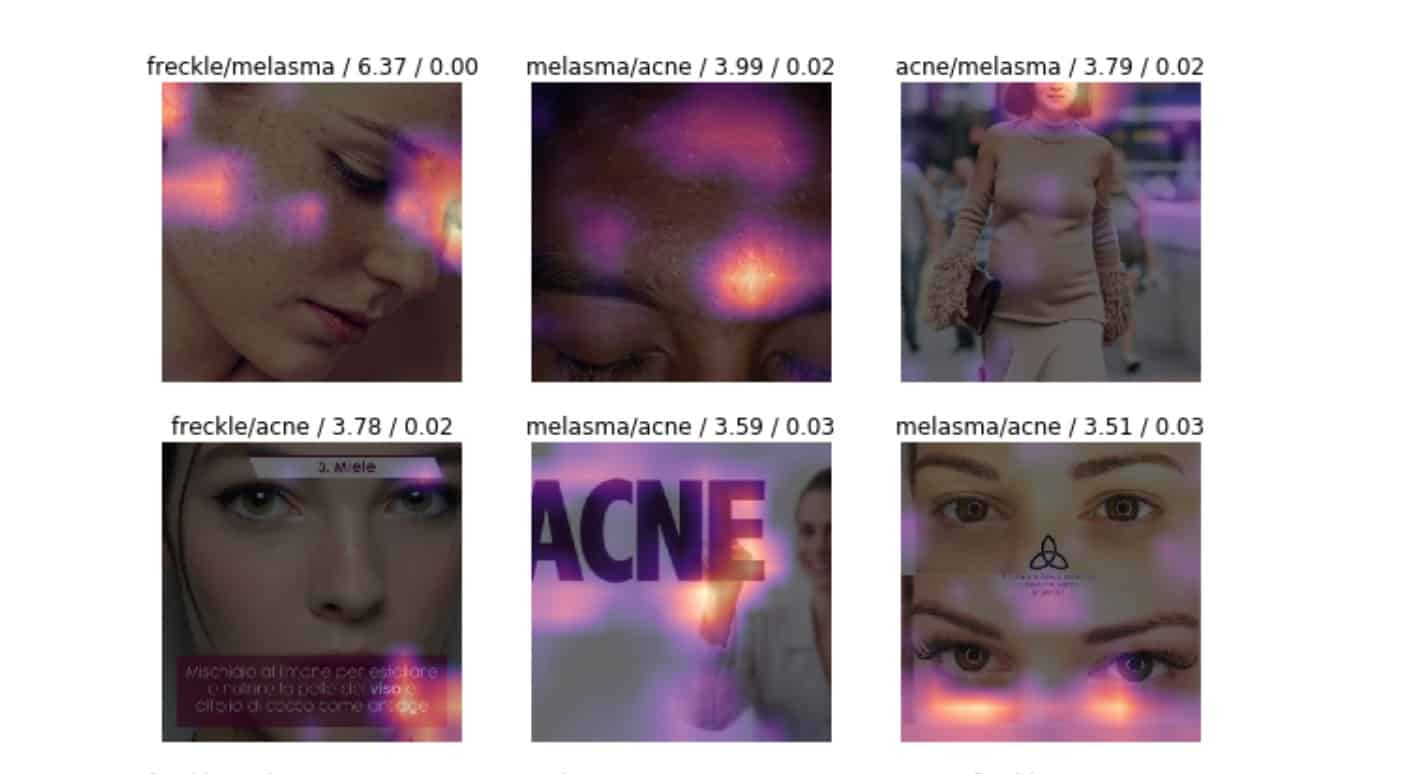

ใน ep.4 นี้เราจะมาลองสร้างชุดข้อมูลปัญหาผิวพรรณของเราขึ้นมาเองแบบง่าย ๆ ด้วย Google Images Search หรือถ้าใครมี Domain Expertise เชี่ยวชาญทางด้านไหน เช่น การแพทย์ การผลิต การตลาด การเกษตร การเงิน แฟชั่น etc. ก็สามารถนำมาใช้ได้ ไม่จำกัด แล้วสร้างโมเดล Deep Learning ด้วย Python ให้เรียนรู้จากรูปในอินเตอร์เน็ต ดูว่าความแม่นยำจะเป็นอย่างไร

Published by Surapong Kanoktipsatharporn

The ultimate test of your knowledge is your capacity to convey it to another. View more posts