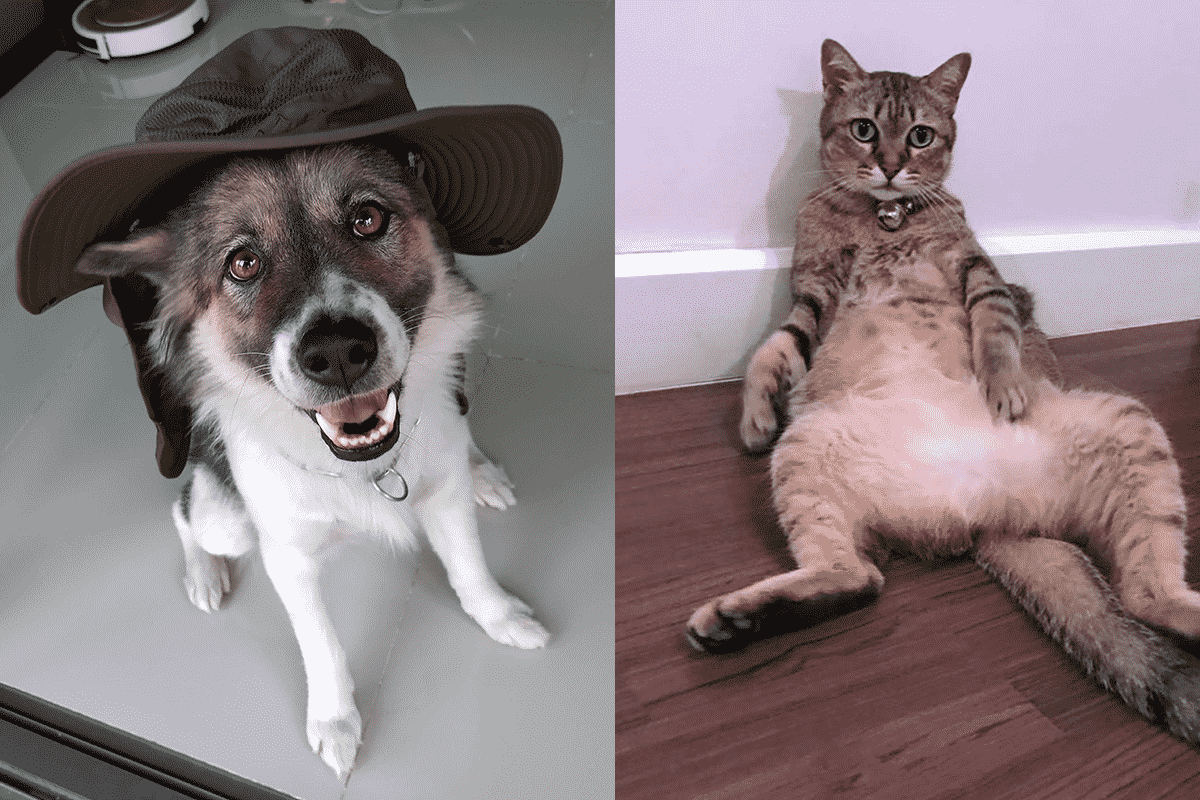

ใน ep นี้ เราจะมาเรียนรู้วิธีการใช้ Deep Learning โดยสร้างโมเดล Deep Neural Network ขึ้นมา แล้วเราป้อนข้อมูลให้ว่า รูปนี้ คือสายพันธุ์นี้ รูปนี้ คือสายพันธุ์นี้ รูปนี้ คือสายพันธุ์นี้ …

แล้วให้โมเดลเรียนรู้ด้วยตัวเอง (Machine Learning) และจนสามารถทำนายสายพันธุ์ หมา และ แมว Image Classification จากรูป ที่โมเดลไม่เคยเห็นมาก่อนได้